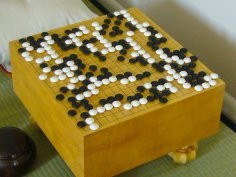

AlphaGo wygrał ostatnią partię z Lee Sedolem

Lee Sedol, mistrz świata w Go, przegrał ostatnią partię z AlphaGo. Tym samym wynik meczu pomiędzy człowiekiem a sztuczną inteligencją został ustalony na 1:4. Mamy do czynienia z wydarzeniem olbrzymiej rangi. Przed niemal 20 laty komputer wygrał z mistrzem świata w szachach. Jednak Go, pomimo znacznie prostszych reguł, była dotychczas terenem niezdobytym przez maszyny. Liczba możliwych kombinacji jest w niej bowiem niewyobrażalnie duża. Tak dużą, że jeszcze na kilka tygodni przed meczem z AlphaGo Lee Sedol mówił, że w bieżącym roku pokona maszynę. AlphaGo okazał się jednak lepszy.

Początek piątej partii należał do Lee Sedola. AlphaGo popełnił bowiem amatorski błąd. Później jednak maszyna z mozołem odrabiała straty i druga część partii była najbardziej interesującą w całym meczu. Do końca nie było wiadomo, komu przypadnie zwycięstwo. Lee Sedol stał przed dylematem, czy powinien zaatakować, czy grać defensywnie. Wygrał w końcu czwartą partię, w której grał ofensywnie. Wówczas jednak grał białymi, w partii piątej zagrał - na własne życzenie - czarnymi. Lee Sedol zwykle woli ofensywny styl gry, jednak miał do czynienia z nieznanym przeciwnikiem, z którym zmierzył się jedynie w czterech partiach.

Rozpatrując wynik meczu trzeba wziąć pod uwagę, że maszyna nie czuje presji, ani się nie męczy. Człowiek ma jednak pewną przewagę - może zmienić strategię. AlphaGo opracowuje swoją strategię na podstawie poprzednich rozgrywek z danym przeciwnikiem i nie jest w stanie zmienić jej w czasie partii.

Po godzinie i 20 minutach AlphaGo wykonał ruch, który komentatorzy uznali za słaby. Jednak maszyna "rozumuje" nieco inaczej niż ludzie. Jej zadaniem jest zmaksymalizowanie szans na zwycięstwo, a nie zmaksymalizowanie marginesu zwycięstwa. Czasem więc wykonuje ruchy, których ludzie do końca nie rozumieją. Po tym ruchu obie strony zaczęły grać bardzo szybko. Komentatorzy ledwo nadążali. Zasady meczu mówiły bowiem, że po tym, jak skończy się czas przyznany każdej ze stron, mają one na wykonanie każdego kolejnego ruchu nie więcej niż 60 sekund. Dzięki swojej agresywnej strategii Lee Sedol zyskał przewagę w prawym dolnym rogu planszy, a AlphaGo popełnił błąd, którego nie popełniłby nawet średnio zaawansowany amator. Szala zwycięstwa przechylała się na stronę Lee Sedola. Po 3,5 godzinach mistrz znalazł się w poważnych tarapatach. Na jego zegarze pozostało 5 minut, a AlphaGo miał do dyspozycji 30 minut. Tymczasem na planszy zostało jeszcze spore terytorium do zdobycia. Gdy skończył się czas Lee Sedola ten miał jedynie 60 sekund na wykonanie każdego ruchu. Raz nie zmieścił się w czasie, więc musiał odczuwać olbrzymią presję, gdyż po trzecim niewykonaniu ruchu w przewidzianym czasie przegrałby partię. W końcu, po pięciu godzinach rozgrywki, Lee Sedol poddał się.

Technologie wykorzystane w AlphaGo są powoli wdrażane przez Google'a do codziennych zastosowań. Część z nich wykorzystano w technologiach rozpoznawania twarzy i komend głosowych. Kolejne są testowane w różnych usługach.

Mecz pomiędzy człowiekiem a maszyną pokazał, jak bardzo rozwinięte są systemy sztucznej inteligencji. Pokazał też, że nie są one doskonałe. AlphaGo popełnia amatorskie błędy. Jednak, co również stało się jasne, potrafi się na nich uczyć i przezwyciężyć kłopoty.

Niezwykle interesującym zjawiskiem może być fakt, że meczem przez tydzień żyła cała Korea. Informowały o nim na czołowych miejscach wszystkie media. Lee Sedol stał się bohaterem narodowym, a na widok Demisa Hassabisa, inżyniera odpowiedzialnego za rozwój algorytmów AlphaGo, ludzie reagowali tak, jak Europejczycy na widok gwiazd popu.

Komentarze (66)

wilk, 15 marca 2016, 18:51

Czyli jednak nietypowe zagranie się nie powiodły.

Flaku, 15 marca 2016, 19:43

Komentatorzy powinni się cieszyć, że AlphaGo nie potrafi jeszcze udzielać wywiadów. W trakcie gier często twierdzili, że nie rozumieją strategii maszyny, a za chwile, że popełniła błąd amatora. Po takiej obrazie nowy mistrz powinien ich zrównać z ziemią soczystą wiązanką

thikim, 15 marca 2016, 19:47

Jak byłem dzieckiem, to miałem kolegę. Grał trochę lepiej ode mnie w szachy. Ogólnie poziom dziecinny był tych gier, ale to chyba nie ma znaczenia.

Jednocześnie w tych czasach miałem swój pierwszy C64 i próbowałem z nim zagrać w szachy. Przegrywałem.

Mój kolega z wielką pewnością siebie mawiał, że on na pewno by nie przegrał bo zagrałby głupio i komputer by zgłupiał.

Ja raczej mam inne doświadczenia. Jak się popełnia błąd to komputer korzysta z tego błędu

Owszem, jak się jest zarąbistym wyjadaczem to można zastosować jakąś technikę która dla komputera okaże się za trudna. O ile zdoła się doprowadzić do ustawienia od którego można tę technikę wykorzystać.

Flaku, 15 marca 2016, 19:57

Być może się powiodły. Skąd wiesz, że te "amatorskie błędy", to nie były właśnie celowe nietypowe zagrania, które sprawiły, że poprzedni mistrz zgłupiał i został pokonany własną bronią

wilk, 16 marca 2016, 23:29

Ale to właśnie Sedola miał zagrać nietypowo ponownie w ostatniej partii, bo twierdził, że wykonał w czwartej (którą wygrał) nietypowy ruch, który według niego zmylił algorytm.

To jeszcze zależy od algorytmu. Te komputerowe szachy zwykle mają wbudowaną potężną bazę otwarć i końcówek, więc błędy gracza zmiotą silnymi posunięciami. AlphaGo zaś wykorzystuje sieci neuronowe i drzewka, więc może zaburzyło mu to „równowagę”.

Jarek Duda, 28 czerwca 2016, 18:30

Coś znacznie ważniejszego niż AlphaGo: http://www.popsci.com/ai-pilot-beats-air-combat-expert-in-dogfight?src=SOC&dom=tw

pogo, 28 czerwca 2016, 22:18

I dopiero gdy takie algorytmy będą prowadziły autonomiczne samochody to będzie można mówić o jakiejś rewolucji w tej kwestii i możliwości wykorzystania tego w cywilnym transporcie.

Problemem są tylko sytuacje gdy jedynymi opcjami do wyboru będzie kogo zabić... Mimo że dobry algorytm będzie miał takich sytuacji kilkadziesiąt razy mniej niż człowiek, to i tak będzie to moralnym wyzwaniem dla twórców oprogramowania.

thikim, 28 czerwca 2016, 22:43

Dlaczego? Można nic nie robić i kogoś się tam zabije bez wybierania.

Jajcenty, 28 czerwca 2016, 23:02

Tak! Moje ulubione: odmawiam wyboru mniejszego zła.

pogo, 28 czerwca 2016, 23:14

Decyzja o braku działania to też działanie.

Jajcenty, 28 czerwca 2016, 23:31

A gdyby mnie tam nie było, to też bym działał?

Jako programista bałbym się pozwu bo mój algorytm skręcił by zabić dwie osoby zamiast trzech. Taki pozew uważam za uzasadniony.

Zanim zabrniemy dalej, wiesz że to problem klasy Kobayashi Maru?

pogo, 28 czerwca 2016, 23:37

Zapomniałem dodać warunek, że gdy możesz zadziałać.

Słynny dylemat z pociągiem. Decyzja by nie przestawiać zwrotnicy to też działanie. Co innego jak nie masz dostępu do jej przestawienia.

Jajcenty, 28 czerwca 2016, 23:59

O tak. I ma wiele rozwinięć. Np. możesz uratować dzieci zrzucając na tory starego grubasa. Niestety sam jesteś za lekki i Twoje poświęcenie nie będzie wystarczające. Większość ankietowanych decyduje, że zabijanie starego grubasa jest nieetyczne i pozwala zginąć dzieciom. Gdyby przestawić zwrotnicę i zabić grubego to ok, ale samemu pobrudzić rączki to już nie. Ach ta hipokryzja mniejszego zła...

glaude, 29 czerwca 2016, 10:50

Test wagonika, to bardziej test na emocje niz na moralność. Ewoluowaliśmy kontaktując się blisko i walcząc, w razie potrzeby, bezpośrednio - a nie za pomocą karabinu, czy guzika odpalającego silosa nuklearnego. Dlatego nasze intuicyjne odczucia nie powinny być wzorem dla maszyn.

Myślę, ze sensowny i prosty algorytm lepiej zadziała w praktyce niz człowiek ze swoim bagazem emocji i ppstaw moralnych wątpliwej wartości.

Gość Astro, 29 czerwca 2016, 11:02

Pewnie tak, ale czy ten prosty algorytm wyniósłby własnoręcznie jak bohaterski kierowca wrocławskiego autobusu "bombę"?

Przy okazji podejrzewam, że w autobusach prowadzonych przez algorytm ilość ich (autobusów ) dewastacji, jak i częstotliwość napraw byłaby większa.

) dewastacji, jak i częstotliwość napraw byłaby większa.

Jajcenty, 29 czerwca 2016, 11:11

A ja myślałem, że będę miał Cię po mojej stronie. Etyka medyczna jest najbliższa mojej filozofii. Zdaje się że lekarz nie rozbierze zbrodniarza na narządy, którymi mógłby uratować ileś tam istnień, nawet jeśli zbrodniarz jest skruszony i w ramach ekspiacji sam na to nalega.

thikim, 29 czerwca 2016, 11:38

W pewnych warunkach tak.

Ale najmniej kosztowne to jest "nie działanie" do oprogramowania. Dawna instrukcja "NOP".

Pomyśl tak:

- mam oprogramować coś tak aby mogło w skrajnej sytuacji wybrać że np. zabija X zamiast Y.

No i jest wtedy problem oprogramowania i odszkodowania, bo celowe zabicie kogoś a przypadkowe to olbrzymia różnica.

Jeśli tego wyboru nie oprogramujesz to po pierwsze masz mniej roboty. Po drugie zabicie kogoś jest tylko i wyłącznie wypadkiem nie mającym nic wspólnego z wolą programisty.

Czasem naprawdę najrozsądniejszą decyzją jest nie robić nic i nie tworzyć sztucznych problemów.

i nie tworzyć sztucznych problemów.

pogo, 29 czerwca 2016, 12:04

Tu masz całkowita rację.

Aż mi głupio, że pomyślałem bardziej jak człowiek niż jak algorytm, w końcu sam jestem programistą.

Ciekawe tylko jaki może być efekt gdy algorytm będzie się uczył na podstawie historycznych przypadków, które zarejestrował.

Czy wykształci nietypowe rozwiązania dla typowych sytuacji?

Czy w ogóle potrzebuje umiejętności nauki?

Afordancja, 29 czerwca 2016, 12:06

Dokładnie tak, nawet nie nazwał bym nic nie robieniem.

1) Zagrożenie na drodze

2) Czy da się uniknąć zagrożenia, bez uszkodzenia innych ludzi

3) Jak najbardziej efektywne hamowanie .

Koniec "programu"

W ogóle nie analizujemy kogo zabijać

Gość Astro, 29 czerwca 2016, 12:07

Myślę, że w omawianej sytuacji zamiast NOP lepszy będzie generator pseudolosowy. Raczej trudno pozwać programistę…

Afordancja, 29 czerwca 2016, 12:39

Wbrew pozorom to nie jest takie głupie, w wersji strong, AI mogła by oceniaj prawdopodobieństwo przeżycia i losuje wg. prawdopodobieństwa przeżycia.

Gość Astro, 29 czerwca 2016, 12:50

Wbrew pozorom Pozory to moje drugie imię (Jęzory Pozory Astro; ukłon w stronę Gombrowicza ).

).

Poważniej, to "koniec programu" jest łatwym do pozwu powodem. Albo jest jazda, albo nie ma jazdy. Bierzesz na klatę wszystko.

Gdyby przyszło co do czego to podejrzewam, że programiści skupiliby się na algorytmie "minimalizowania zabitych sztuk". Oczywiście zabijając "jedną sztukę" mogliśmy zabić potencjalnego Mozarta albo Einsteina oszczędzając pięciu żuli. Dzięki Jajcenty, że "przemycasz" swoją filozofię…

thikim, 29 czerwca 2016, 12:57

O właśnie. I unikamy 10 sympozjów na temat kogo i dlaczego można zabić. Sympozjów gdzie i tak mimo wielu godzin rozmów nie ma żadnych konkretnych wniosków

NOP podałem tak humorystycznie.

Afordancja, 29 czerwca 2016, 13:19

Zauważ, że "koniec programu" jest po za wyliczeniem, czyli to nie jest koniec programu, tylko mój dopisek w komentarzu

Programiści poszli by zgodnie z prawem, w tłumy jest zakaz wjeżdżania. Generalnie staramy się aby wszystko odbyło się w ramach "jezdni", czyli nie ma, że omijamy dziecko na jezdni aby uwalić dorosłego na chodniku, po prostu hamujemy.

Program zawsze jeździł by zgodnie z przepisami, i wystarczy "proste" prawo, że nie angażujemy w to trzeciej strony (czytaj, ludzi na chodniku), to jedyne co staramy się robić to hamujemy, wymijamy, itd. ale to wszystko, programista nie weźmie nic na klatę, będzie pisał tak jak mówi prawo