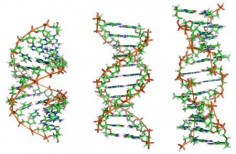

Japończycy stworzyli sztuczne DNA

Japońscy naukowcy twierdzą, że stworzyli pierwsze sztuczne DNA. W datowanym na 23 lipca Journal of the American Chemical Society Masahiko Inouye wraz ze współpracownikami z University of Toyama informuje o zbudowaniu stabilnej sztucznej nici DNA.

Jeśli rewelacje Japończyków się potwierdzą, to ich odkrycie doprowadzi do powstania całej serii nowych materiałów, umożliwi też zbudowanie komputerów opartych na DNA.

Obliczenia oparte na DNA wykorzystują cały kwas dezoksyrybonukleinowy jako "sprzęt", a poszczególne białka to "programy". Zachodzące reakcje służą do przeprowadzania obliczeń.

Prototypowe komputery z DNA już powstają, jednak dopiero stworzenie sztucznego DNA umożliwi postęp prac nad nimi, gdyż specjaliści będą mogli dowolnie je projektować, w zależności od przewidywanych zastosowań. Takie komputery będą nie tylko niezwykle małe, ale również bardzo wydajne. Olbrzymią zaletą DNA jest również fakt, iż może ono przechowywać olbrzymią ilość informacji. Pół kilograma kwasu dezoksyrybonukleinowego wystarczy, by zapisać w nim dane zawarte na wszystkich obecnie wykorzystywanych dyskach twardych.

Komentarze (12)

mikroos, 8 lipca 2008, 14:43

Moim zdaniem nazywanie tego "pierwszym sztucznym DNA" to skrajne nadużycie. Synteza całkowicie sztucznych nici DNA jest możliwa od kilkudziesięciu lat.

shg, 8 lipca 2008, 15:30

News sprzed prawie roku, czy z przyszłości?

mikroos, 8 lipca 2008, 15:57

Bardzo często wstępna informacja o odkryciu jest publikowana znacznie wcześniej w internecie, a dopiero później w czasopismach fachowych.

inhet, 8 lipca 2008, 16:10

Nie tylko możliwa, ale też realizowana na skalę półprzemysłową. Toteż podejrzewam, że w artykule chodzi o coś innego - pewnikiem o tę stabilność. 23 lipca powinno się to wyjaśnić.

mikroos, 8 lipca 2008, 22:25

DNA nie należy do mało stabilnych związków. Znosi całkiem nienajgorzej temperatury w zakresie szerszym niż dla elektroniki, podobnie zmiany wilgotności. Nie bardzo rozumiem tego newsa i chętnie do niego wrócę po 23.07.

inhet, 8 lipca 2008, 22:31

DNA lubi mutować - to jest właśnie ta jego niestabilność.

mikroos, 8 lipca 2008, 22:34

A, chyba, że o tym mówisz. Z drugiej jednak strony, nie tak trudno je ochronić. Ołowiana puszka i szczelne naczynie załatwiają sprawę. Jeżeli nowe nici nie będą syntetyzowane, wówczas błędy polimerazy także odpadają. Ale dobra, koniec ze spekulacjami, czekam na konkrety

ubi, 8 lipca 2008, 23:01

A czy taki komputer będzie klasyfikowany jako maszyna czy jako organizm?

waldi888231200, 9 lipca 2008, 00:12

Idzie era robokopów - terminatorów - cywilizacji maszyn 8).

galen, 9 lipca 2008, 00:42

Największym chyba problemem z tymi bionicznymi komputerami będzie czas dostępu do danych. Tu przecież wszystko opiera się na reakcjach chemicznych. Aby te przebiegały szybko potrzebne są konkretne enzymy. Jak miałby wyglądać taki komputer? Probówka z kabelkami?

To wymaga podejścia do informatyki od strony chemii organicznej.

BTW, mikroos, ołów chyba nie przyjaźni się z organiczną I nici raczej muszą być syntetyzowane. Jak inaczej zmienić dane już istniejące? Nie jest łatwo wyciąć kawałek DNA i wstawić inny. Wektory wirusowe mogłyby coś zdziałać.

I nici raczej muszą być syntetyzowane. Jak inaczej zmienić dane już istniejące? Nie jest łatwo wyciąć kawałek DNA i wstawić inny. Wektory wirusowe mogłyby coś zdziałać.

Polecam http://pl.wikipedia.org/wiki/Komputer_DNA

mikroos, 10 lipca 2008, 11:44

Ale co ma jedno do drugiego? Przecież puszkę można czymkolwiek powlec od wewnątrz Myślę, że takie niuanse naprawdę można pominąć, bo to nie jest trudne do obejścia.

Myślę, że takie niuanse naprawdę można pominąć, bo to nie jest trudne do obejścia.

Zgadzam się (choć można odpowiednio manipulować DNA np. z użyciem enzymów restrykcyjnych), ale, z drugiej strony, w tej notce także nie ma nic na temat zmiany sekwencji istniejącej nici. Mamy zbyt mało danych, żeby je oceniać.

Jarek Duda, 12 lipca 2008, 13:31

Chodzi o użycie innych zasad azotowych, tu jest ładnie rozrysowane:

http://www.sciencedaily.com/releases/2008/07/080707091915.htm

Połączenia pomiędzy parami powinny mieć podobną siłę, ale pewnie te zmiany wpłyną na konformacje całej nici.

Problem w tym, że normalne enzymy będą raczej nie będą z tymi zasadami kompatybilne...

Odnośnie komputerów DNA...

To raczej nie są komputery które mają szybko działać w czasie rzeczywistym - syntetyzujemy duże ilości materiału pod konkretny problem z konkretnymi danymi i mieszamy korzystając z olbrzymiej równoległości ... na końcu sprawdzamy czy np. dany fragment jest odsłonięty - w każdym razie wszystko jest bardzo czasochłonne i raczej daje rozwiązania z pewnym prawdopodobieństwem.

Czy natomiast mogą zwiększyć możliwości takich komputerów...?

Żeby tak było, musielibyśmy raczej używać ich razem ze 'starymi' zasadami ... tylko jak jest z ich interakcją? W celach obliczeniowych powinna być bardzo jednoznaczna, z czym myślę że będzie problem.

Moooooże udałoby się w ten sposób poprawić trochę stałe złożoności, ale uważam że jest to raczej tylko ciekawostka, pokaz siły. Lepiej się teraz skupić na tym co już mamy - dobrze zrozumieć narzędzia dane przez naturę narzędzia i rozbudować zupełnie nowe, stochastyczne podejścia do algorytmiki.