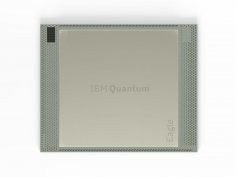

IBM zaprezentował 127-kubitowy procesor kwantowy Eagle

IBM zaprezentował 127-kubitowy procesor kwantowy Eagle. Dzięki niemu, jak zapewnia koncern, klienci firmy będą mogli wykorzystać niedostępne dotychczas zasoby obliczeniowe, co ma się stać krokiem milowym w kierunku wykorzystania obliczeń kwantowych w codziennej praktyce. Eagle ma bowiem wkrótce zostać udostępniony wybranym partnerom IBM-a.

Postrzegamy Eagle'a jako krok na drodze technologicznej rewolucji w historii maszyn obliczeniowych. W miarę, jak procesory kwantowe są rozbudowywane, każdy dodatkowy kubit dwukrotnie zwiększa ilość pamięci, jaką potrzebują komputery klasyczne, by symulować taki procesor. Spodziewamy się, że komputery kwantowe przyniosą realne korzyści, gdyż rosnąca złożoność procesów obliczeniowych, jakie są w stanie wykonać, przekroczy możliwości komputerów klasycznych, czytamy w informacji prasowej IBM-a.

Inżynierowie Błękitnego Giganta nie mieli łatwego zadania. Prace praktyczne i teoretyczne nad maszynami kwantowymi, opartymi na zasadach mechaniki kwantowej, są prowadzone od dziesięcioleci i od dawna wiemy, że komputery takie są w stanie przeprowadzać obliczenia niedostępne maszynom klasycznym. Jednak ich zbudowanie jest niezwykle trudne. Nawet najmniejszy wpływ czynników zewnętrznych może spowodować dekoherencję kubitów, czyli doprowadzić do stanu, w którym zawarta w nich informacja zostanie utracona.

Eagle zawiera niemal 2-krotnie więcej kubitów niż jego poprzednik, 65-kubitowy Hummingbird. Jednak jego powstanie wymagało czegoś więcej, niż tylko dodania kubitów. Inżynierowe IBM-a musieli opracować nowe i udoskonalić istniejące techniki, które – jak zapewniają – staną się podstawą do stworzenia ponad 1000-kubitowego układu Condor.

Kolejnym niezwykle ważnym elementem nowego procesora jest wykorzystanie techniki multiplekosowania odczytu, znaną już z procesora Hummingbird R2. We wcześniejszych układach kwantowych każdy kubit wymagał zastosowania osobnego zestawu elektroniki zajmującej się odczytem i przesyłaniem danych. Taka architektura może sprawdzić się przy kilkudziesięciu kubitach, jednak jest zbyt nieporęczna i niepraktyczna przy ponad 100 kubitach, nie wspominając już o 1121-kubitowym Condorze, który ma powstać za 2 lata. Multipleksowanie odczytu polega na łączeniu sygnałów odczytowych z wielu kubitów w jeden, dzięki czemu można znakomicie zmniejszyć ilość okablowania i komponentów elektronicznych, co z kolei pozwala na lepsze skalowanie całości.

Najbardziej interesującymi informacjami, których jeszcze nie znamy, są wyniki testów Quantum Volume (QV) i Circuit Layer Operations Per Second (CLOPS). Quantum Volume to stworzony przez IBM-a system pomiaru wydajności kwantowego komputera jako całości. Bierze pod uwagę nie tylko same kubity, ale również interakcje pomiędzy nimi, działania poszczególnych elementów komputera, w tym błędy obliczeniowe, błędy pomiarowe czy wydajność kompilatora. Im większa wartość QV, tym bardziej złożone problemy może rozwiązać komputer kwantowy. Z kolei zaproponowany niedawno przez IBM-a CLOPS to benchmark określający, na ilu obwodach kwantowych procesor jest w stanie wykonać operacje w ciągu sekundy. Maszyna Eagle nie została jeszcze poddana testom wydajnościowym i jakościowym.

W ubiegłym roku Honeywell ogłosił, że jego System Model H1, korzystający z zaledwie 10 kubitów, osiągnął w teście QV wartość 128. Nieco wcześniej zaś 27-kubitowy system IBM-a mógł się pochwalić QV 64. Widzimy zatem, że sama liczba kubitów nie mówi jeszcze niczego o wydajności samej maszyny.

Komentarze (1)

cyjanobakteria, 16 listopada 2021, 21:59

Teraz to nawet dzieciaki w Minecraft projektują działające komputery z 8-bitowymi procesorami