Nowa architektura tranzystorów przedłuży życie Prawa Moore'a

Badacze z IBM-a, GlobalFoundries i Samsunga stworzyli nową architekturę tranzystorów, dzięki której Prawo Moore'a będzie obowiązywało jeszcze przez lata. Jakby jeszcze tego było mało, nie wykorzystali przy tym ani węglowych nanorurek, ani żadnego innego teoretycznego rozwiązania, ale przystosowali już używane procesy produkcyjne i materiały.

Przemysł półprzewodnikowy od dziesięcioleci tworzy coraz mniejsze podzespoły. Dzięki temu na pojedynczym układzie scalonym możemy umieścić coraz więcej tranzystorów, co przekłada się na coraz większą moc obliczeniową układu, coraz lepszy stosunek mocy do zużywanej energii oraz coraz niższa cenę.

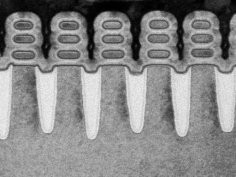

Ostatni duży postęp technologiczny w przemyśle półprzewodnikowym miał miejsce w 2009 roku, gdy zaprezentowano nową architekturę tranzystorów o nazwie FinFET. Produkcja tego typu tranzystorów rozpoczęła się w roku 2012, umożliwiając przejście do 22-nanometrowego procesu produkcyjnego. FinFET był rewolucją, gdyż pozwolił na pierwszą od dziesięcioleci znaczącą zmianę struktury tranzystorów, pozwalając na wykorzystanie architektury 3D w miejsce dotychczas stosowanego systemu 2D. Struktura FinFET to pojedynczy kwadrat, którego trzy boki są pokryte bramkami, mówi Mukesh Khare, wiceprezes ds. badań nad półprzewodnikami w IBM-ie.

Od tego czasu upłynęło jednak 5 lat i FinFET dochodzi do kresu swoich możliwości. Obecnie wykorzystuje się ją w procesie 10-nanometrowym i powinna wystarczyć do procesu 7-nanometrowego. Jeśli nadal chcemy zmniejszać procesory i być pewnymi, że będą one działały, to około 5 nanometrów musimy przejść do innej architektury procesora – mówi Dan Hutcheson, dyrektor firmy VLSI Research, która specjalizuje się w badaniach nad wytwarzaniem półprzewodników.

Wynalazek IBM-a, GlobalFoundries i Samsunga nadszedł w samą porę. Innowacja polega na zmianie struktury FinFET z wertykalnej na horyzontalną, dzięki czemu powstaje czwarta bramka. Możemy wyobrazić sobie to jako FinFET obrócone na bok i ułożone jedno na drugim – stwierdza Khare. Jeśli zaś chodzi o skalę, to mamy tutaj gigantyczny postęp. W nowej architekturze sygnał elektryczny przechodzi przez przełącznik, którego szerokość wynosi 2-3 szerokości nici DNA.

To wielki postęp. Jeśli możemy zmniejszyć tranzystory, upakujemy więcej tranzystorów na tej samej powierzchni, a więc uzyskamy więcej mocy obliczeniowej z tej samej powierzchni, mówi Hutcheson. W przypadku nowej architektury oznacza to, że o ile w 7-nanometrowym procesie upakujemy na podstawce 20 miliardów tranzystorów, to przy procesie 5-nanometrowym na tej samej podstawce zmieści się ich 30 miliardów. Eksperci z IBM-a obliczają, że pozwoli to albo na uzyskanie o 40 procent większej wydajności przy tym samym zużyciu energii, albo na zmniejszenie zużycia energii o 75% przy tej samej mocy obliczeniowej układu.

Procesory z nową architekturą tranzystorów trafią na rynek nie wcześniej niż w roku 2019. Jednak to idealna pora. Mniej więcej wtedy bowiem pojawi się potrzeba przejścia na jeszcze mniejszy proces technologiczny, pozwalający na dokonanie kolejnego postępu w wielu dziedzinach, od rozwoju sieci 5G, poprzez autonomiczne samochody po sztuczną inteligencję. To wszystko jest w wysokim stopniu uzależnione od coraz większych mocy obliczeniowych. Możemy je uzyskać tylko z tego typu technologii. Bez nich się zatrzymamy, dodaje Hutcheson.

Komentarze (16)

wilk, 5 czerwca 2017, 14:56

A według mnie to naturalna konsekwencja rozwoju technologicznego i nikt z inżynierów powyższym celem się nie kierował.

Ergo Sum, 5 czerwca 2017, 15:50

Wg mnie Prawo Moore'a w ogóle nie jest konsekwencją rozwoju lecz .... ekonomii. Sprawdza się dobrze, gdyż taki postęp gwarantuje największe możliwe zyski. Po co robić od razu 10 kroków rewolucji technicznej, skoro można każdy krok sprzedać jako rewolucja i wziąć za niego kasę. KAŻDA korporacja myśli w ten sposób i powolny wzrost jest bardziej rodzajem "niepisanej zmowy". Jak najmniejsze nakłady i jak największe zyski.

pogo, 5 czerwca 2017, 16:02

Uwielbiam tę teorię spiskową.

Wciąż nie mogę jednak zrozumieć dlaczego w superkomputerach wciąż używa się procesorów wykonanych w technologii dostępnej na rynku konsumenckim? Czy nie taniej byłoby od razu dać naukowcom 10 procesorów z generacji, która trafi oficjalnie na rynek za 10 lat, zamiast pchać tam 2000 zwykłych procesorów serwerowych i wydawać kolejne dziesiątki milionów na zmuszenie ich do wspólnej pracy?

Wydatki dla producenta sprzętu dużo mniejsze, a kasę może wziąć taką samą.

thikim, 5 czerwca 2017, 17:54

Ergo Sum lubi chyba teorie spiskowe

Ale w tym co napisała jest ziarno prawdy. Prawo Moore'a jest kombinacją postępu i ekonomii

Bombę termojądrową odłożyły tak bardzo na później że nie zdążyły jej zbudować

Bombę termojądrową odłożyły tak bardzo na później że nie zdążyły jej zbudować

Całkiem logiczne jest to że australopiteki zanim zabrały się za bombę termojądrową to zajęły się ogniem

Zresztą wyniki prawa Moore'a modyfikowano już.

Superman, 5 czerwca 2017, 21:23

Ile znasz teorii spiskowych, że akurat tę uwielbiasz?

Ja uwielbiam ludzi, którzy automatycznie czyjeś zdanie zmieniają na słowo teoria i dodają słowo spisek - właśnie dzięki Tobie mamy nową, bo użyłeś słowa klucz

A dla mnie to ani "wg mnie" ani "teoria spiskowa", tylko ekonomiczna rzecz dokonywana. W wielu rzeczach/dziedzinach można to zauważyć np. w lekach.

PS.

celowa kolejność?

radar, 5 czerwca 2017, 22:30

A to (tylko) od kupca zależy co producent oferuje do sprzedaży?

Nikt przyczepić się nie może, w końcu zawsze kupujesz coś "najlepszego" na rynku, tak?

ww296, 6 czerwca 2017, 07:42

Dokładnie podsumowali temat Thikim i Superman.

Po prostu takie "działanie spiskowe" wynika z przyczyn niekoniecznie spiskowych tylko korzystnych w określonej sytuacji. Zapewne gdyby w pewnych dziedzidzinach z premedytacją przyspieszyć postęp efekty byłyby lepsze (szybsze). Jednak jak praktycznie w każdej aktywności takie działanie niosłoby również negatywne konsekwencjie. Jakie? Na przykład nierównomierne rozdzielania zasobów (zarówno materialnych jak i intelektualnych) przez co w pewnych kierunkach postęp byłby mniejszy niż obecnie.

pogo, 6 czerwca 2017, 09:54

Trzeba pamiętać, że nowa technologia potrzebuje testów. Zrobiliśmy procesor 7nm w czasach gdy wszyscy klepią 32nm... super, ale nie wiemy jeszcze na ile stabilnie to działa, a sprawdzenie tego zajmie kilka lat. Często okazuje się, że jednak nie działa tak dobrze i trzeba poprawiać technologię. Też jest to kwestia nakładów finansowych. Czasem szybsze zejście z rozmiarem tranzystora może się nie zwrócić, bo wybudowanie fabryki będzie droższe niż przychody z produkcji.

Lubię większość teorii spiskowych, są zabawne. Uwielbiam mniej więcej co drugą

wilk, 6 czerwca 2017, 16:46

Nie mówię o tym, że prawo Moore'a to konsekwencja rozwoju, ale że jest nią ta nowa architektura. Naukowcy nie siedzieli w pocie czoła, by nie przekroczyć deadline, bo jutro wydajność powinna się już podwoić, a robili swoje. Prawo Moore'a to tylko i wyłącznie obserwacja. Aczkolwiek która faktycznie napędza, ale jedynie medialny hype.

Błędne zrozumienie tego podejścia. Tu nie chodzi o to, że w kosmicznych laboratoriach CIA/NSA/NASA/PAN mają już opracowane (czy tam przejęte od alienów) tajne hiperstrunowe procesory pracujące w PHz, ale nie chcą się chwalić, tylko o to, że nie opłaca się projektować dłużej i sprzedawać sprzętu o takim skoku rozwojowym, podczas gdy bardziej opłacalne jest projektowanie i sprzedawanie mniejszych kroczków. To tak samo jak z rynkiem motoryzacyjnym od kilkunastu lat (znacznie mniej istotnych innowacji, znacznie więcej pomysłów jak wycisnąć kasę lub sprzedać prawie to samo w innym opakowaniu).

Oczywiście wielu rzeczy nie sposób przeskoczyć, tak jak przykład z australopitekami. Ale to wymaga zrozumienia tego w jaki sposób powstaje rewolucyjny wynalazek, bo strzelanie w takim przypadku analogią o dzikusach z karabinami plazmowymi jest mimo wszystko paralogizmem.

Ergo — skok jest możliwy, ale nieopłacalny, no może poza wizjonerami, ale do tego trzeba mieć miliardowe zaplecze. Motorem innowacji nie jest już złoty strzał, a stały przypływ gotówki.

Nieco błędne zestawienie „nowa technologia” i „procesor Xnm”. To jest proces technologiczny. Innowacją jest pomysł zrobienia kilku rdzeni, równoległych potoków, przewidywania rozgałęzień, wprowadzenia cache, mikrokod i in. Znane od dawna procesy: więcej cache, więcej RAM, więcej GHz, więcej „rdzeniuffff!”, mniej nm, to jest już wyciskanie, choć pociąga za sobą często nowe technologie, które muszą być wpierw opracowane (więcej GHz/mniej W -> mniej nm -> litografia).

thikim, 6 czerwca 2017, 17:03

Raczej chyba nie

Jeśli chodzi o postęp. Gdy jest możliwy i opłacalny postęp to się go robi. Dlaczego? Bo się na tym zarabia z warunku opłacalności.

Ale nie zawsze jest opłacalny.

Urządzenia smartfonopodobne próbował wprowadzić na rynek MS jakieś 25 lat temu Skończyło się klapą. I to nie MS sam spiskował przeciwko sobie.

Skończyło się klapą. I to nie MS sam spiskował przeciwko sobie.

Na smartwatchach regularnie producenci tracą

Po prostu wprowadzanie każdej nowej technologii jest ryzykowne.

Powodem powolnego wdrażania nowych technologii nie jest chciwość i chęć zarobienia na starych, tylko strach przed klapą nowych.

Nie każdy to rozumie

wilk, 8 czerwca 2017, 16:37

Przed klapą nowych, ale i przed byciem zjedzonym przez potężniejszych konkurentów.

thikim, 8 czerwca 2017, 20:13

Nowych to chyba jednak konkurencja nie ma. Bo inaczej nie byłyby takie nowe.

Ponadto co znaczy zjedzenie? Że ktoś mnie wykupi dając, za firmę w którą włożyłem 1 mln, 100 mln?

Ergo Sum, 9 czerwca 2017, 00:49

Kwestia spojrzenia na Prawo Moora jako prawo ekonomiczne w ogóle nie ma NIC wspólnego ze spiskiem. To raczej wynik właśnie obserwacji. Wypadkowa kilku czynników. Z jednej strony postęp musi istnieć żeby nowy telefon się sprzedał jako "nowy". Musi być to taki postęp, który maksymalnie dużo ludzi pchnie do zakupu nowego telefonu. Z drugiej strony trzeba jak najmniej wydać na ten postęp, aby koszty były jak najniższe. To nie spisek - to czysta ekonomia. Ekonomia rozumiana przez wszystkich graczy. I tu dochodzimy do drugiego poziomu wyglądającego jak spisek, ale spiskiem nie będącego.

Na rynkach o wysokim progu wejścia nie ma ma wielu graczy. Każdy gracz wie jak wygląda maksymalizacja zysków i rozumie też że konkurencji na tym zależy. Ekonomia opiera się na prostej teorii gier, opracowanej jeszcze przez Johna Nasha - w której gracze dążą do wygranej (czyli wyeliminowania gracza). Ale założenie to jest błędne. Oni nie dążą do wyeliminowania konkurencji, oni dążą do zarobienia pieniędzy. Jeśli zarobek można osiągnąć bez eliminacji konkurencji to nie ma potrzeby tego robić. Powstaje sytuacja wyglądająca jak spisek, albo zmowa cenowa - ale to zjawisko całkowicie naturalne. (Był nawet parę lat temu niezwykle ciekawy eksperyment wśród tysięcy studentów polegający na przeprowadzonej prostej grze - udowadniający że ta podstawa ekonomii mówiąca o wyeliminowaniu konkurencji jest wadliwa). Nota bene - dlatego przez wiele lat mieliśmy bardzo wysokie ceny SMS-ów u wszystkich operatorów pomimo tego że ich koszt wynosił już wtedy grubo poniżej 1 grosza. Wszyscy w Polsce "jakby w spisku" ustawiali ceny na poziomie kilkudziesięciokrotnie wyższej.

Do tego dochodzi państwowe zabezpieczanie przed monopolizacją. A jeśli jakiś mały gracz opracuje coś bardzo przełomowego? .... Jeden z wielkich graczy kupuje patent, wsadza go do sejfu i wszyscy śpią spokojnie

Tak więc wracając do Prawa Moora myślę że to nie jest żaden spisek i że prawo się jeszcze sporo utrzyma. Wyjątek stanowią jedyne te dziedziny które mają znacznie wyższe podstawy ideologiczne. W nich widać odstępstwa od Prawa Moora - np. potanienie kosztów badań DNA - bo ludziom zależy tu na "idei" a nie koniecznie na czystym zysku.

Jeśli chcielibyśmy przyspieszyć postęp - musielibyśmy wymyślić jakiś kij i jakąś marchewkę, żeby maksymalizacja zysków nie opłacała się. Nie wiem - może jakąś komisję wielkich nagród za znaczny postęp? Może kary za zbyt małą "rewolucję" typu zakrzywiona ramka telefonu?

Flaku, 9 czerwca 2017, 13:12

Tak, wykupują patent, wkładają do sejfu, a potem wydają miliardy na wymyślenie swojego rozwiązania.

Calamity J, 10 czerwca 2017, 01:41

Postęp technologiczny, to jest kwestia drugorzędna. Podstawą jest zaspokajanie wykreowanych lub istniejących potrzeb konsumentów. Prawo Moore'a już dawno nie działa w swojej podstawowej formie, bo praktycznie nikogo nie interesuje skalowanie częstotliwości dla jednowątkowego przetwarzania. Klient domowy jest bardziej zainteresowany miniaturyzacją, energooszczędnością i konwergencją funkcjonalną, a jak widać ostatnio korporacyjni również idą w kierunku rozwiązań do massive parallel processing. Skoro wystarczy dokładać do klastra kolejne "zwyczajne" serwery i całość skaluje się logarytmicznie względem problemu, to inwestowanie w prawo Moore'a nie ma podstaw biznesowych.

Patrząc na to do czego jest potrzebna czysta moc w przetwarzaniu widać obecnie takie rzeczy jak np. kodowanie wideo i gry/VR. Wykreowanie potrzeby na moc obliczeniową to np. przejście z 1080p na 4k. Jak za 5 lat będzie przejście z 4k na 8k, to znowu cała rzesza kreatorów treści wideo będzie potrzebowała skoku wydajności, żeby montaż wideo nie trwał X razy dłużej. Podobnie z grami i VR - wyprowadzenie tego z rozpalonych częstotliwością PieCy do laptopów czy komórek, konsol mobilnych itd. będzie wymagało postępu technologicznego. To idzie zawsze w parze. Po co komu byłby teraz potrzebny GPU, który wyświetli rozdzielczość 8K w 120Hz, skoro nie ma monitora, nie ma treści, nie ma gier itd. które by pozwoliły cokolwiek na tym zrobić?

wilk, 11 czerwca 2017, 17:36

Z tym paralellizmem - pełna zgoda, ale jeśli chodzi o masówki. Bo są zastosowania specjalne, gdzie potrzebny jest sprzęt klasy hi-end czy nawet specjalizowany. I to właśnie stamtąd spływają potem nowinki, które są już zostają odpowiednio skrojone.